摘要:目前数据质量问题已成为制约高校信息化发展的主要问题,需要利用数据治理建设全校级别的数据管理流程体系才能有效全面地提升数据质量。数据治理是指将数据作为高校资产而展开的一系列标准化工作,是对数据的全生命周期管理,其目标是提高数据的质量。本文结合高校特点提出数据治理模型,给出了具体的实施方法步骤和评估办法,具有较强的可操作性,能够充分发挥数据治理的效果。

一、引言

高校信息化经过多年的发展,很多高校已积累了大量的业务和相关数据,但是因为数据质量不高、冗余数据大量存在和数据可用性不高,使很多数据处理工作还需要通过人工来确保正确,浪费了大量的人力和时间。造成这样的问题,主要是因为高校的信息化建设往往是多系统分散进行,在建设时缺乏统一的数据规划和相关标准,虽然做了大量的数据集成,但是因为数据不规范、不一致、冗余、部分数据无法共享等原因,使数据质量低下、可用性不高。因此我们需要通过数据治理建设全校级别的数据管理流程体系来进行数据全生命周期的管理。

数据治理是指将数据作为资产而展开的一系列的标准化工作,是对数据的全生命周期管理。数据治理是需要技术与管理相结合并进行持续改善的管理机制,贯穿整个数据管理的全生命周期,通常需要制定组织架构、政策制度、技术工具、数据标准、流程规范、监督及考核等方面内容。数据治理的目标是提高数据的质量,保证数据的安全性,实现数据资源在高校各业务部门的有效整合和共享,从而提升高校信息化水平,更有效地发挥信息化作用。

目前,数据治理的研究往往从两个方面展开:一个是从数据质量管理方面,定义数据质量活动和相应的角色职责;[1][2]而最近越来越多的研究引入IT治理的经验和办法,从全局考虑治理框架和生命周期管理,比较常见的是以国际数据管理协会(DAMA)[3]、数据治理协会(DGI)[4]等机构提出的治理框架具有较强的借鉴意义。在高校信息化领域,许晓东等[5]提出高校数据治理可以分为数据的获取和抽取、整合和分析、解释和预测几个阶段,给出了基本的实施步骤,但是缺少整体的框架。包冬梅等将数据治理应用到高校图书馆,并提出了CALib数据治理参考框架。[6]

二、数据治理模型

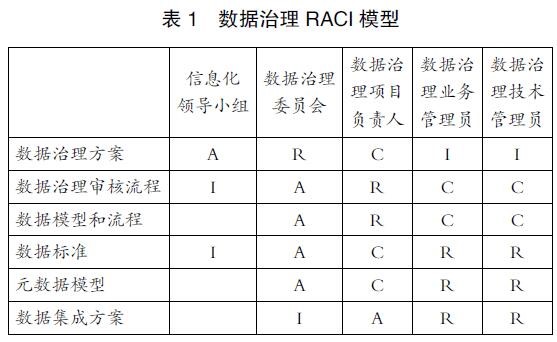

数据治理模型需要明确阐明数据治理的主要目标、相关角色、治理活动和相应的职责。[7]在这里我们可以建立RACI(R=Responsible,即负责执行活动的角色;A=Accountable,即对活动负全责的角色;C=Consulted,即拥有完成项目所需的信息或能力的人员;I=Informed,即应及时通知结果的角色)模型矩阵(见表 1)来确定相应的角色和活动的职责关系。

其中角色包括以下五类,也构成了高校数据治理的组织架构:

信息化领导小组:审议数据治理发展规划,推进数据治理在全校落实。

数据治理委员会:主持数据治理组织工作,制定数据治理相关规章制度。

数据治理项目负责人:业务部门和信息中心负责人,管理数据治理管控活动,对数据质量负责。

数据治理业务管理员:负责其所负责的业务数据定义、业务规则以及执行相关的正常标准。

数据治理技术管理员:确保数据治理被有效地理解、使用和共享,满足治理和完整性标准。

数据治理主要活动包括制定数据治理方案、制定数据治理审核流程、制定数据模型和流程、制定数据标准、制定元数据和制定数据集成方案。其中数据治理方案将从战略角度来统筹和规划,对数据资产和系统进行清理,确定数据治理的范围,明确数据治理的流程及职责,确定数据治理的评估指标、方法;数据治理审核流程是指当发现数据质量有误时,需要启动变更管理流程,由相关业务部门和信息中心确认变更内容和执行方法,并在学校全局得以应用,确保数据质量。而后续的步骤将涉及具体的实施方案,在第三章进行详细介绍。

三、主数据管理实施

高校数据主要包括实体数据和业务数据。实体数据描述的是具体的对象,例如教师、学生、资产、教室等;业务数据描述实体发生的业务活动,例如学生选课、教师教学等,其本质是多个业务实体之间的活动关系。其中核心的实体数据往往会在多个业务系统中共享使用,这些实体数据和其属性就被称为主数据。ISO 8000-2-2012中定义“主数据描述了对组织起到基础作用的实体,这些实体是独立的,并且是组织进行事务处理需要参考的数据实体”。[8]主数据包括元数据、属性、定义、角色、关系和类别等。[9]

由于主数据作为多个业务系统中最核心的、尤其需要共享的基础数据,分散管理的主数据由于不具备一致性、准确性和完整性,使内部数据共享受到阻碍,数据资产的价值无法有效开发,因此对主数据进行治理也是数据治理任务中的重中之重。在高校,数据治理的实施就可以先在主数据范围内选择不同主题进行。主数据管理旨在从高校的多个业务系统中抽取主数据并进行整合,然后进行数据治理,并以服务的方式把统一、完整、准确的主数据分发给其他业务系统应用。选择主数据进行治理,可以选择最为重要的数据,集中精力把有限的资源投入到需要的地方。

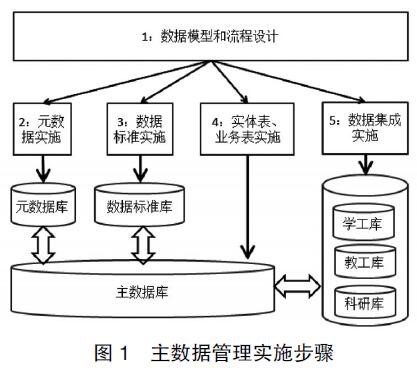

主数据管理可以参考图1进行实施:

主数据管理是个长期性、螺旋性上升的过程,通过实施步骤,不断进行数据规范化改进与沉淀,实现数据全生命周期建设。

(1)数据模型和流程设计:根据业务规则,识别由业务产生、控制和使用的数据实体,按照数据实体的联系,对数据实体进行分析、筛选、聚类、归并等,建立数据模型,数据模型包括实体(理解为表)、属性(理解为包含所表示的实体的特征的列)、实体之间的关系和完整性规则,以及所有这些部件的定义,输出数据ER(实体联系)模型;梳理数据集成方案,明确数据流向,输出DFD图(数据流图);明确数据生产者,数据生产者、使用者、拥有者与管理者的职责与权限,输出数据U/C(使用/创建)矩阵。

(2)元数据实施:元数据(metadata)描述了如何理解数据,作为数据的显性知识包括了术语、业务规则和限制、字段格式、字段范围、字段类型、数据的使用方法和权限管理。元数据对数据的管理、数据的使用和数据的质量都非常关键。

(3)数据标准实施:确定数据定义、数据格式以及数据应用标准,制定数据定义规则与数据应用规则,最终确定标准化的代码标准与规则体系。代码标准给出了其他数据相应字段需要参照的内容,例如学科代码、课程代码等。

(4)实体表、业务表实施:实体表包含了高校数据的主要实体信息;业务表描述实体发生的业务活动。两者都是复合表,涵盖了实体和业务的所有信息,需要关联到其他的代码表、对象表和关系表等。对于表中的每一个字段,我们需要明确数据的限制和数据类型。

(5)数据集成实施:通过数据集成转换工具,依据集成方案进行数据集成实施,需要完成数据集成到主数据库,主数据库提供数据共享给需要的业务系统,在实施过程中需要保障安全权限。

四、数据质量评估

数据质量的提升是数据治理的最终目标,因此需要建立相应的评估模型来对数据治理结果进行评估。这里我们可以参考数据质量评估框架DQAF(Data Quality Assessment Framework),该框架是国际货币基金组织(IMF)以联合国政府统计基本原则为根本构建的数据质量评估框架体系,从数据质量的完备性、及时性、有效性、一致性和完整性五个维度来进行数据质量评估和提升。[10]

完备性:数据提供内容需要是完整和充分的。可以从数据的宽度和深度两个方面度量,即包含所有需求希望的属性字段(宽度)和需求希望的数据量(深度)。可以通过检测治理的数据汇总数据与控制记录提供的汇总数据进行比较。

及时性:从时间维度度量数据从更新到被主数据管理的满足程度。可以用数据在其源头被更新到能够提供给主数据进行管理的时间差进行度量。

有效性:是数据对数据标准、数据模型、业务规则、元数据和参考数据等符合程度。例如,对输入数据的值与某个数据标准的有效值进行比较。

完整性:用于度量哪些数据是缺失的或者哪些数据不可用,例如超出阈值。该维度体现了对基本数据的质量测量。可以通过校验规则来保证数据完整性。

一致性:用于度量哪些数据的值在信息含义上是冲突的,是对各种不同的数据库、应用和系统中所存储或使用的信息等价程度的测量。例如某些考评结果,有的是优、良、差;有的是甲、乙、丙,这就造成了数据度量不一致。因此满足一致性是进行数据集成的基础。

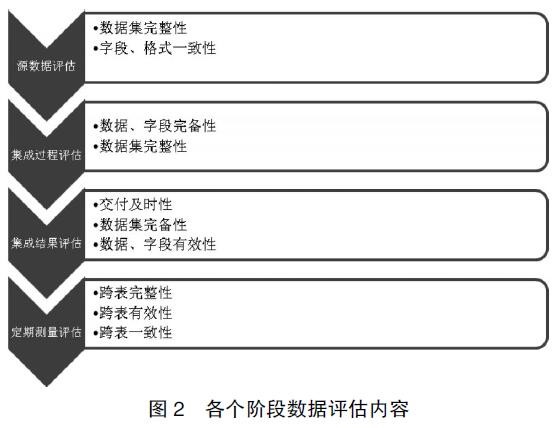

在主数据管理过程中可以在四个阶段进行数据质量评估,包括源数据评估、集成过程评估、集成结果评估和定期测量评估。图2给出了每个阶段的评估内容。可以分别从数据、字段、数据集和跨表数据等进行各个维度的评估。

五、结论

数据将成为高校的宝贵资产,它具有真正的、可衡量的价值。在高校信息化建设的过程中,通过开展高校数据治理以提高数据质量,可以有效提高数据价值,为组织决策的制定提供帮助。同时,通过对高校信息化建设中数据治理的研究,可以认清在高校信息化中存在的问题,有效促进我国高校信息化的建设。

来源:中国教育信息化网